CS234 Winter 2019 2강

- Given a Model of the World 공부

강의 슬라이드 : http://web.stanford.edu/class/cs234/schedule.html

기록을 위한 것이지 보여지기 위한 것이 아닙니다.

RL 초보자이기 때문에 이해한 것이 정답과 다를 수 있습니다.

지난 시간 정리

모델의 경우 reward model와 dynamics model로 나누어 설명이 가능하며 현재의 상태에 따른 어떻게 세상이 변해가는지에 대한 기술로 stochastic model / deterministic model이 있습니다.

오늘 배울 것은 특정 상태에서의 행동을 하거나 다음 상태의 분포가 무엇인지에 따른 행동을 취할 때 무슨 일이 일어날 것인가를 배울 것이다.

어떻게 결정을 취할 것인가 make decision

계획 문제를 행동할 것인가 planning problem

언제 delayed consequences의 행동을 취할 것인가

= 당장의 보상보다 긴 시간의 보상을 최적화하기위해 희생하는 것

state가 아닌 observation일 수도 있다.

지난 시간 전체 history에 대한 markov를 취한 것과 다르게

오늘은 immediately sensors에 대한 고려를 함

a stochastic process

주식 시장에 투자를 하던지 하지 않던지에 상과없이 주식 시장은 시간에 따라 변화

Markov Process

Markov Chain : transition dynamics를 충족하는 연속된 랜덤 상태

sequences of random state

start state라고 불리는 상태는 어디인가?

여기서는 정의하지 않았지만 일반적으로 steady-state distribution이라 생각

stationary distibution은 상태들에 따른 약간의 분포를 집약한다.

configuration 1. 배열, 배치; 배열 형태 2. 환경 설정

$S_1^T=[1,0,0,0,0,0,0]$ init state

calculate : $P \cdot S_1$

Ex) Start from S4

S4, S5, S6, S7, S7, S7

S4, S4, S5, S4, S5, S6

S4, S3, S2, S1 와 같이 움직이는 것이 가능

14:00

process가 deterministic하다면 2개는 동일/ stochastic하다면 다르다

항상 같은 다음 상태로 간다면 처음 상태의 시작과 상관없이 기댓값은 단일 기댓값과 동일

그러나 우리는 일반적으로 stochastic decision process에 관심이 있고

이는 평균이 다르다

약간 어려운 부분

Gamma 0 : 즉각 보상

만약 길이가 유한하다면 수학적 편의를 위해를 위해 gamma=1도 가능

accuracy : ${1 \over \sqrt{n}}$

Markov structure

미래는 현재를 고려했을 때 과거에 독립적이며 value function을 분해할 수 있게 한다.

$V=R + \gamma PV$ : R,P는 알고있다.

$V-\gamma PV = (I-\Gamma p)V = R$

$V = (I-\gamma P)^{-1}R$

Solving directly requires taking a matrix inverse $O(N3)$

$|V_k - V_{k-1}| < \epsilon$

3가지 방법을 봤음 1. Simulation 2. Analytically 3. Dynamic Programming

Recall iterative way of computing

gamma=0 : immediate reward

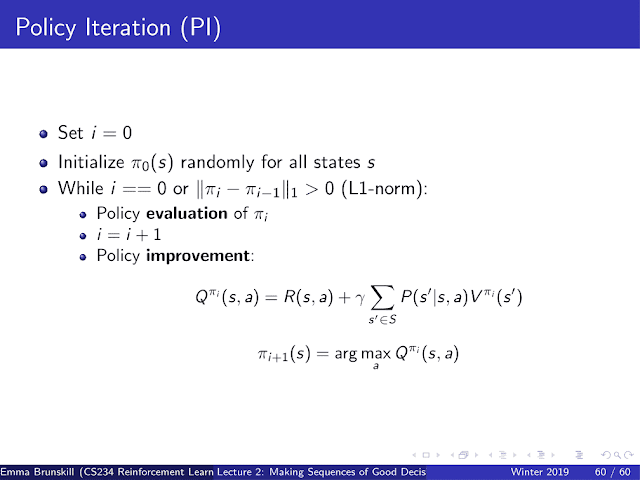

deterministic decision policy는 상태로부터 행동을 mapping하는 것이다.

$\Pi_{i+1}(s) = argmax_a Q^{\pi_i}(s,a)$

$max Q^{\pi_i}(s,a) \ge Q^{\pi_i}(s, \pi_i(s)),a=\pi_i(s)$

$max_a Q^{\pi_i}(s,a) \ge R(s,\pi_i(s)) +\gamma\sum_{s^\prime} P(s^\prime|s,a)V^{\pi_i}(s^\prime) = V^{\pi}(s$

$\pi_{i+1}(s) = argmax_a Q^\pi(s,a)$

for each s

strange thing :

오래된 정책을 따르는 것이 아니라 새로운 정책을 따르게 됨

정책 policy를 반복해서 사용하지 않는다.

이유 : monotonic improvement 단조 증가