CS234 Winter 2019 3강

- Model-Free Policy Evaluation 공부

강의 슬라이드 : http://web.stanford.edu/class/cs234/schedule.html

기록을 위한 것이지 보여지기 위한 것이 아닙니다.

RL 초보자이기 때문에 이해한 것이 정답과 다를 수 있습니다.

Copyright to Stanford CS

dynamics난 보상 모델 없이 수행하는 정책 평가에 대해 오늘 알아볼 것

지난 시간 우리는 Markov Reward Process MRP에 대해 정의를 내림

0~1 사이의 수인 Gamma, discount factor를 이용했음

dynamic programming을 통한 정책 평가 Policy Evaluation

dynamics와 transition은 이 수업에서는 상호교환이 가능한 의미

vector인 value function을 0으로 초기화한 후에 유한한 상태와 행동을 수반한 반복

given dynamics/transition reward model r

$|V_k^{\pi} - V_{k-1}^{\pi}| < \epsilon$

k가 클 때 상당히 좋은 예측치를 나타냄

반면 k=1 나쁜 결과를 얻게될 것

다음 상태에 대한 Expectation 예측치를 구하는 것

$V^{\pi}(s) = r(s, \pi(s)) + \Gamma \sum_p (s^\prime k, a)V_{k-1}^{\pi}(s^\prime)$

value function is a stationary quantity

trajectory 경로라는 뜻으로 start point에서 end point로 이동하는 경로를 의미함

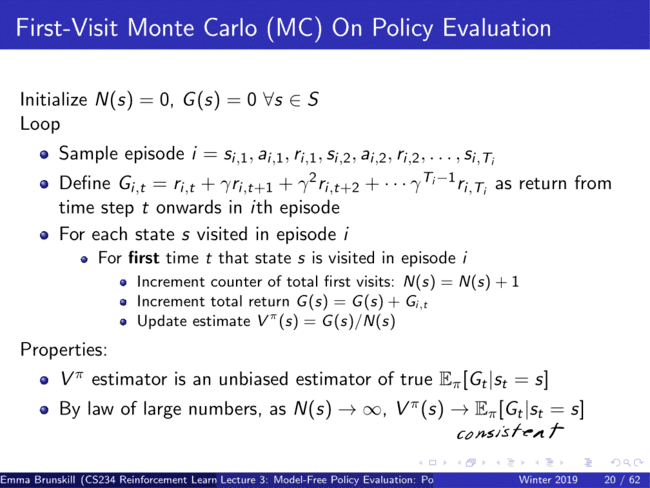

Monte Carlo Policy Evaluation의 장점은 구체적인 dynamics나 보상을 요구하지 않는다

많은 반복과 estimate 추정치를 통해 나 자신을 평가

MDP의 존재 유무에 큰 영향을 받지 않음

trajectory 탄도, 궤적, 궤도

초기화 이후 처음의 state에 대해서 update를 시킨다.

correlated -> data : no longer i.i.d condition

Mars rover domain 예시

우리가 직접 방문한 곳에 대해서만 1

2번 방문한 S2에 대해서는 1

s3,s2,s1에 대해서 update

정리하면 아래와 같다

예시의 Trajectory 경로는 s3->s2->s2->s1->terminal 종료지점

이 때의 Value를 구하는 방법은 아래와 같다($\gamma=1$)

거꾸로 계산해야하기 때문에

$S_1 : G_{i,1}=1, S_2:reward_2+\gamma G_{i,1} =0+1= 1, S_2:reward_2+\gamma G_{i,2}=0+1=1, S_3:reward_3 + \gamma G_{i,2}=0+1=1$

결과적으로 위의 First visit MC estimate of V의 각 상태는 위와 같다.

다만 주의점은 S2의 경우 처음의 state에 대해서만 표기를 해야한다.

Every Visit MC estimate of S2의 경우는 모든 state에 대해서 estimate를 해줘야한다.

때문에 Value의 값은 아래와 같이 계산한다.

$S_2 : {2 \over 2}$

분자의 2는 처음 $V(S_2)$와 두 번째 $V(S_2)$의 합을 뜻한다. 때문에 1+1=2

분모는 두 번의 $S_2$의 state 개수를 의미한다. 이는 N(s)를 의미한다.

process 안에 작은 loop를 통해 영원히 돌아가며 종료되지 않는 것에 대해서 MC를 사용할 수 없다. G안에 있는 discount를 가지는 것은 도움이 되지 않는다.

bootstrap 부트스트랩 ((예비 명령에 의해 프로그램을 로드(load)하는 방법))

Temporal Different Learning은 Monte-Carlo와 Dynamic Programming을 합친 방법으로

Model-Free이며 BootStrap

즉각적인 업데이트 Immediately updates들은 그 지식을 바로 사용할 수 있는 장점이 있음

both be high-variance and be biased

proxy 1. 대리(권) 2. 대리인 3. (측정·계산하려는 다른 것을 대표하도록 이용하는) 대용물

alpha=1 use TD-target : 이전 추정치를 잊어버리게 됨

asymptotic 점근선의

consistent vs being unbiased estimator

MC unbiased, high-variance, consistent

TD some bias, much lower variance than MC

zero converge with tabular representations

-> not always converge once

tabular 표로 나타낸

always terminate

MC : V(A) = 0 there's only one trajectory we have an A and it got a zero reward.

TD : V(A) = 3/4 bootstrap the value from A.

k의 경우 episode

t = time step을 의미한다.

여기까지가 3강 수업 끝